Etikk: Rammer for ansvarlig KI

Det er ikke alt som er lov, som er lurt. (Det er heller ikke nødvendigvis slik, at alt som er lurt er lov.) Etisk refleksjon kan hjelpe oss til å se klarere når slike konflikter oppstår. PHS ønsker at PrevBOT skal leve opp til prinsipper for etisk og ansvarlig kunstig intelligens, og i sandkasseprosjektet har vi prøvd å konkretisere hvordan de kan klare det.

Også for de etiske problemstillingene har vi fokusert på forskings- og utviklingsfasen av prosjektet. Samtidig er spørsmål om hva som er «etisk riktig» i utviklingsfasen, ofte avhengig av hva vi ser for oss som konsekvenser og gevinster i bruksfasen. Derfor har vi i dette kapittelet i større grad enn de foregående sett for oss alternative måter PrevBOTen kan operere på, uten at det nødvendigvis reflekterer hva PHS faktisk har planlagt.

Målet

Hvordan kan PHS og PrevBOT måles på om de holder det etiske nivået de ønsker? Hva kjennetegner en utviklingsprosess av, og et produkt med, ansvarlig kunstig intelligens?

«Ansvarlig kunstig intelligens» er ikke et beskyttet uttrykk, som du kan smykke KI-verktøyet ditt med om det oppfyller alle punkter på én spesifikk kravliste. Det er et uttrykk for kunstig intelligens som holder et visst nivå av ansvarlighet, når det kommer til hvordan systemet – både i utvikling og bruk – har konsekvenser for brukere og samfunnet.

Etisk, ansvarlig eller tillitsvekkende KI?

- «Etisk KI» refererer primært til å justere kunstig intelligente systemer i tråd med etiske prinsipper og verdier. Det kan være å sikre at systemet ikke viderefører fordommer eller urettferdighet, og at de bidrar positivt til menneskelig velferd og rettigheter.

- «Ansvarlig KI» går på operasjonalisering av etikk til praktiske tiltak, og å sikre at KI-systemer utvikles og brukes med en bevisst innsats for å unngå skade og misbruk. Ansvarlig KI defineres som regel med at utviklingen og bruken av KI-teknologi skjer på en måte som er ansvarlig, transparent og bærekraftig.

- «Tillitsvekkende KI» er et begrep som ofte brukes av Den europeiske union, oversatt til «pålitelig og tillitsvekkende» i den norske KI-strategien, og sikter til at KI-systemer skal være lovlige, etiske og robuste. Det er ikke nok at teknologien bare er i tråd med lover og regler, men den skal også være utviklet og implementert på en måte som tjener brukernes og samfunnets tillit ved å være pålitelig, sikker og transparent.

Selv om det er betydelig overlapp mellom disse konseptene, ligger forskjellene ofte i vektleggingen: etisk KI fokuserer på de moralske aspektene, ansvarlig KI på ansvarlighet og operasjonalisering av denne etikken, og tillitsvekkende KI på å tjene og opprettholde offentlig tillit gjennom overholdelse av lovlige, etiske og tekniske standarder.

Flere forskjellige instanser har utformet prinsipper og kriterier for kunstig intelligens. Først og fremst finnes etiske retningslinjer for tillitsvekkende KI fra 2019, utarbeidet av en ekspertgruppe på oppdrag fra EU-kommisjonen. OECD har utviklet sine prinsipper for kunstig intelligens, som oppfordrer til innovasjon og ansvarlig vekst av KI som respekterer menneskerettighetene og demokratiske verdier. UNESCO utarbeidet i 2022 anbefalinger for etisk KI. Mens konsulentselskapet PwC utarbeidet ni prinsipper for etisk KI på oppdrag fra World Economic Forum. Etter hvert har akademiske institusjoner, tankesmier og teknologiaktører som Google og Microsoft kommet med forskjellige tilnærminger til etisk, ansvarlig og tillitsvekkende KI. Flere av disse prinsippene og retningslinjene er generelle og mest rettet mot politisk styring. Andre er mer konkrete, og dermed nyttige for utviklerne. For eksempel inneholder retningslinjene fra EU-kommisjonens ekspertgruppe en grundig sjekkliste.

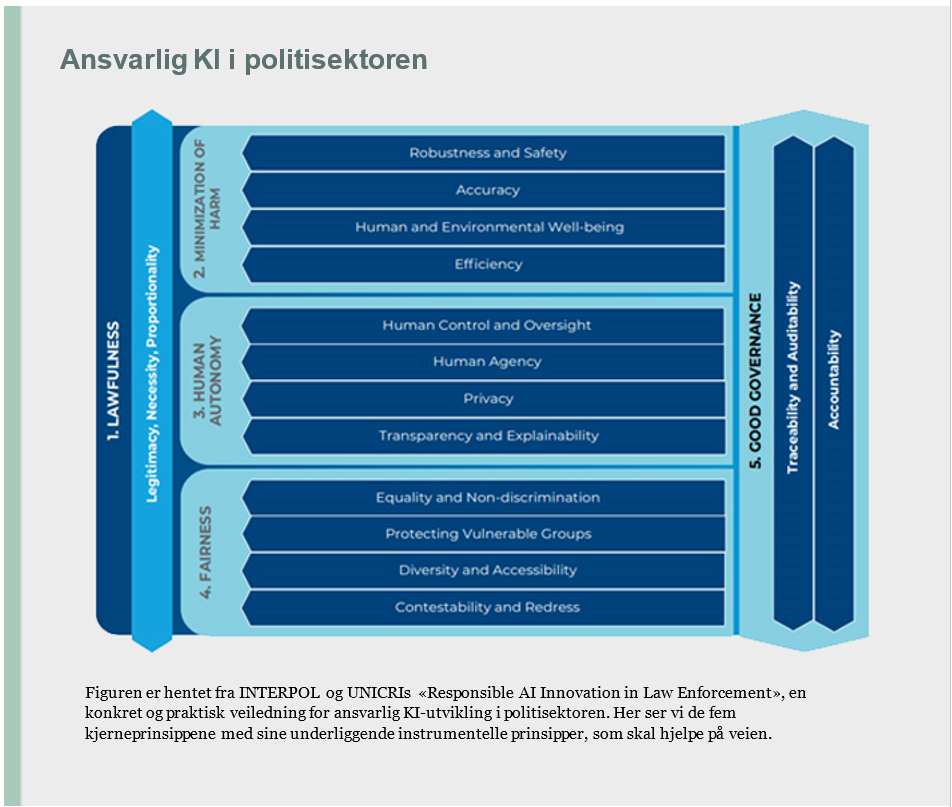

Så finnes det også domenespesifikke retningslinjer for ansvarlig KI, som for eksempel innenfor helsevesenet og finanssektoren. Relevant for PrevBOT-prosjektet, er det at INTERPOL og UNICRI har utviklet prinsipper for ansvarlig innovasjon av kunstig intelligens spesielt myntet på utvikling innenfor politimyndigheter.

IEEE har også utformet standarder for ansvarlig og etisk utvikling av kunstig intelligens. De har standarder for spesifikke utfordringer, som IEEE P7001, som fokuserer på åpenhet om autonome systemer, IEEE P7002, som tar for seg databeskyttelse og personvern, eller IEEE P7003, som er rettet mot algoritmisk skjevhet. I tillegg har de utarbeidet den mer overordnede og omfattende veiledningen Ethically Aligned Design (EAD), som fremhever nøkkelprinsipper for å sikre at utviklingen av kunstig intelligens og autonome systemer er i tråd med etiske normer og verdier.

Etikk i den nasjonale KI-strategien

I sandkasseprosjektet velger vi å se til Nasjonal strategi for kunstig intelligens, der det er definert syv etiske prinsipper for kunstig intelligens, basert på retningslinjene fra EU-kommisjonens ekspertgruppeDet PrevBOT-prosjektet bør strekke seg etter, er altså:

-

KI-baserte løsninger skal respektere menneskets selvbestemmelse og kontroll

Utvikling og bruk av kunstig intelligens skal bidra til et demokratisk og rettferdig samfunn ved å styrke og fremme enkeltmenneskets grunnleggende friheter og rettigheter. Den enkelte skal ha rett til ikke å være underlagt en automatisert behandling hvis beslutningen systemet fatter berører dem i vesentlig grad. Mennesker skal være inne i beslutningsprosessene for å kvalitetssikre og gi tilbakemelding i alle ledd i prosessen («human-in-the-loop»). -

KI-baserte systemer skal være sikre og teknisk robuste

Kunstig intelligens skal være bygget på systemer med teknisk robuste løsninger som forebygger risiko og som bidrar til at systemene fungerer slik de er tiltenkt. Risikoen for uintenderte og uventede skader skal minimeres. Teknisk robusthet er også viktig for systemenes nøyaktighet, pålitelighet og etterprøvbarhet. -

KI skal ta hensyn til personvernet

Kunstig intelligens som bygger på personopplysninger, eller som retter seg mot personer, skal følge personvernforordningen. -

KI-baserte systemer må være gjennomsiktige

Beslutninger tatt av systemer basert på kunstig intelligens, skal være sporbare, forklarbare og gjennomsiktige. Det betyr at man som enkeltperson eller juridisk person skal ha mulighet til å få innsikt i hvorfor en beslutning som gjelder dem ble som den ble. Sporbarhet muliggjør både revisjon og forklaring. Gjennomsiktighet oppnås blant annet ved å gi informasjon om behandlingen til den registrerte. Gjennomsiktighet handler også om at datasystemer ikke skal utgis for å være mennesker – mennesker skal ha rett til å få vite om de samhandler med et KI-system. -

KI-systemer skal legge til rette for inkludering, mangfold og likebehandling

Ved utvikling og bruk av kunstig intelligens, er det særlig viktig å være oppmerksom på at KI bidrar til inkludering og likestilling, og at diskriminering unngås. Datasett som brukes til å trene opp KI-systemer kan inneholde historiske skjevheter, være ufullstendige eller uriktige. Identifiserbare og diskriminerende skjevhet bør fjernes i innsamlingsfasen hvis det er mulig. Utvalgsskjevhet («bias») kan motvirkes ved å innføre kontrollprosesser som analysere og korrigerer systemets beslutninger i lys av formålet. -

KI skal være nyttig for samfunn og miljø

Kunstig intelligens skal utvikles med hensyn til samfunnet og miljøet, og skal ikke ha negativ innvirkning på institusjoner, demokratiet og samfunnet som helhet. -

Ansvarlighet

Kravet om ansvarlighet utfyller de andre kravene og innebærer at det skal innføres mekanismer som sikrer ansvarlighet for løsninger basert på KI og deres resultater, både før og etter implementering av løsningene. Alle KI-systemer skal ivareta muligheten for revisjon.

Kunstig intelligens og forskningsetikk

Den nasjonale strategien peker også på at forsking på kunstig intelligens må skje i henhold til anerkjente forskningsetiske normer. I tillegg viser strategien til at den nasjonale forskningsetiske komité for naturvitenskap og teknologi (NENT) har avgitt en egen forskningsetisk betenkning om kunstig intelligens, der de lanserer ni prinsipper for KI-forsking innenfor tre områder:

- Ansvar for utviklingen og bruken av autonome systemer:

Forskning på KI skal sikre menneskeverd, lokalisere ansvar, være inspiserbar og bidra til informert samfunnsdebatt. - Samfunnsovergripende konsekvenser og forskningens samfunnsansvar:

Forskning på KI må erkjenne usikkerhet og sikre bred involvering. - Stordata:

Forskning på KI må ivareta personvern og hensyn til enkeltpersoner, sikre etterprøvbarhet og kvalitet og bidra til rettferdig tilgang til data.

Hvordan etiske problemstillinger konkret kan vurderes opp mot de relevante prinsippene fra den nasjonale strategien, demonstrerer vi mot slutten av dette kapitlet. Først vil vi prøve å kartlegge best mulig hvilke etiske problemstillinger som ligger i PrevBOT-prosjektet, og se på hvilke verktøy og avklaringer som kan legge til rette for at de etiske vurderingene blir gode.