Innledning

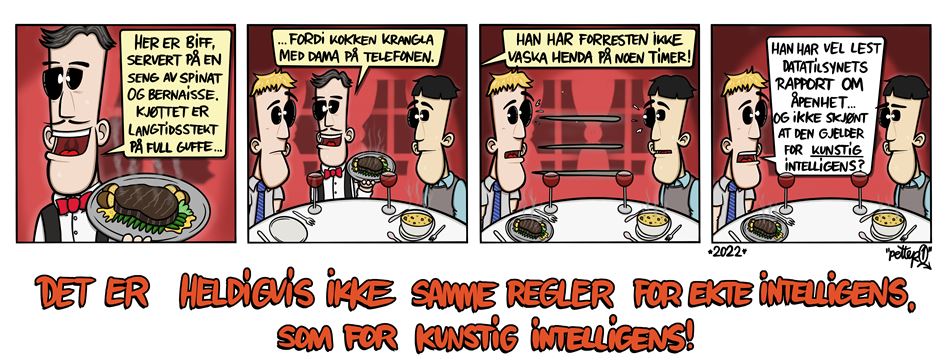

Regelverket setter klare krav til åpenhet. Men det gir ikke sylskarpe grenser og en tydelig oppskrift på hvordan man skal være åpen. Det må gjøres egne vurderinger i hvert enkelt tilfelle. Nettopp derfor vier vi så god plass til eksemplene i denne rapporten, fordi vurderinger og tiltak i disse eksemplene fra virkeligheten kan ha overføringsverdi til andre som har lignende spørsmål.

Hva slags informasjon må man gi? Hvor detaljert må informasjonen være? Hvordan bør man informere? Og hvor og når bør informasjonen gis? Regelverket setter krav og gir brukeren rett til informasjon, men hvordan dette skal implementeres i praksis må vurderes fra sak til sak. Dette er ikke en komplett guide til alle sider av åpenhet ved bruk av kunstig intelligens. Men vi trekker frem noen sentrale sandkassediskusjoner vi tror kan ha nytteverdi for andre.

Tillit er et tema som går igjen i eksemplene. Hvis folk skal være villige til å ta i bruk løsninger og dele opplysninger, må de ha tillit til at løsningen fungerer etter formålet og ivaretar personvernet på en god måte.

Datatilsynets personvernundersøkelse fra 2019/2020 viste tydelige tegn til en nedkjølingseffekt i befolkningen, altså at hvis folk er usikre på hvordan opplysningene om dem blir brukt, endrer de adferd. Over halvparten av de spurte har unnlatt å bruke en tjeneste på grunn av usikkerhet knyttet til hvordan personopplysninger samles inn og blir brukt. Hele to av tre føler at de har liten kontroll og er maktesløse når det gjelder flyten av personopplysninger på internett. Det er lett å anta at denne nedkjølingseffekten ikke bare gjelder internett, men at skepsisen smitter over på andre former for digital deling av personopplysninger, som i møte med kunstig intelligente verktøy.

Om rapporten

Denne rapporten tar først for seg en gjennomgang av de mest sentrale lovkravene knyttet til åpenhet ved bruk av kunstig intelligens. Videre presenterer vi tre prosjekter fra Datatilsynets regulatoriske sandkasse, der åpenhet har vært viktige tema. Til slutt har vi sammenfattet en huskeliste for åpenhet i kunstig intelligens.

Enten du er en programmerer som sitter midt i utviklingen eller en gründer med en gryende idé, om du jobber for en stor virksomhet eller en liten oppstartsbedrift: Vi tror denne rapporten kan være nyttig for mange av dere som utvikler, benytter eller vurderer å anskaffe kunstig intelligente løsninger. Og vi håper du finner den både avklarende og inspirerende, og at den kan være med å bidra til at du lykkes med din kunstig intelligens-satsing.