Åpenhet ved bruk av kunstig intelligens i offentlig forvaltning

NAV ønsker å bruke maskinlæring til å forutse hvilke sykmeldte brukere som vil ha behov for oppfølging to måneder frem i tid. Dette skal hjelpe NAV sine veilederne med gjøre mer treffsikre vurderinger, som igjen skal spare NAV, arbeidsgivere og de sykmeldte for unødvendige møter.

Målet med dette sandkasseprosjektet var å avklare lovligheten ved bruk av kunstig intelligens i denne sammenhengen, og utforske hvordan profileringen av sykmeldte kan gjøres på en rettferdig og åpen måte.

I dette prosjektet så vi på vi på åpenhet rettet mot NAV-veilederne. For at beslutningsstøttesystemet skal fungere optimalt trenger de som skal ta den endelige avgjørelsen relevant informasjon om det algoritmiske forslaget. Dette prosjektet er et eksempel på viktigheten av åpenhet for andre enn bare sluttbruker.

Stoler vi på algoritmen?

Gode forklaringer av algoritmen og dens prediksjoner øker tilliten hos de som skal bruke systemet, noe som er helt sentralt for å oppnå den ønskede verdien. De flere tusen NAV-ansatte som jobber med brukerveiledning spiller derfor en avgjørende rolle.

Systemet som predikerer sykefraværslengde er et beslutningsstøttesystem, men hva skjer hvis systemet i praktisk anvendelse blir et beslutningssystem? En veileder i NAV gjennomgår mange saker i løpet av en vanlig arbeidsdag. Hvis det virker som om algoritmen gir konsekvente gode anbefalinger kan det jo være fristende å alltid følge den. Veilederen tenker kanskje at algoritmen sitter på så mye data at den vet best, og at det skal litt til for å ikke følge anbefalingen? Hvor lett er det for en nyansatt å ikke følge anbefalingen til algoritmen?

Eller hva hvis NAV-veilederne syns at algoritmen gir merkelige anbefalinger, og ikke stoler på dem? En konsekvens av det vil kunne være at veilederne konsekvent ikke bruker verktøyet som beslutningsstøtte. Det ville også ha vært uheldig fordi hele hensikten med løsningen er å hjelpe veilederne til å ta gode valg, slik at innkallingene oftere treffer riktig. Ideelt sett vil en slik modell redusere de tilfeldige variasjonene blant NAV-veilederne og føre til mer enhetlig praksis, i tillegg til å redusere kostnader.

I sandkassen diskuterte vi risikoene for at NAV-veilederne lener seg for mye eller for lite på beslutningsstøttesystemet, og hvordan legge til rette for at systemet oppleves som en reell støtte for veilederne og blir brukt på en god og riktig måte. At NAV-e får god opplæring og instrukser i hvordan algoritmen fungerer og skal brukes, samt en meningsfull forklaring i enkelttilfeller, er viktig for å redusere risikoen for en «snikautomatisering» eller at den ikke tas med i vurderingen i det hele tatt.

Når NAV-veilederne forstår modellens oppbygning, virkemåte og oppførsel, vil det være enklere å vurdere prediksjonen på et selvstendig og trygt grunnlag. I tillegg kan forklaringen bidra til å hjelpe veilederne å avdekke diskriminering, uønsket forskjellsbehandling og feil. Her vil en forklaring knyttet til en enkelt avgjørelse være supplert med informasjon knyttet til utfallet for enkelte grupper det er naturlig å sammenlikne med.

Forklaring av modellen

Her er et eksempel på hvordan en generell forklaring om hvordan modellen opererer, kan se ut for veilederen som bruker systemet.

Hvordan ser en meningsfull forklaring ut?

Et spørsmål vi har diskutert i sandkassen er hvordan en meningsfull forklaring ser ut i praksis i NAVs tilfelle. Målgruppene for åpenhet i løsningen er de sykmeldte og NAV-veiledere. Forklaringene er både globale, altså på systemnivå, og lokale utfallsforklaringer. De to ulike nivåene vil følgelig ha delvis ulike målgrupper, og det vil stilles ulike krav til hvordan de innrettes.

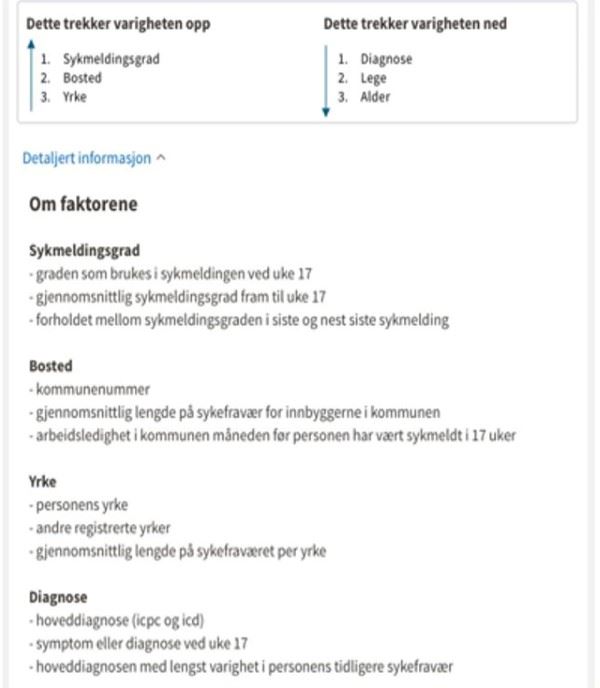

NAV ønsker å informere i forkant av behandlingen om at brukeren har rett til å protestere mot at det i det hele tatt skal gjøres en prediksjon basert på en profilering. De ønsker også å informere om hvordan modellen er bygget og hvilke variabler som inngår. NAV vurderer også å informere den individuelle brukeren om de viktigste faktorene som trekker den predikerte sykefraværsvarigheten opp og de viktigste faktorene som trekker den ned.

En meningsfull forklaring er ikke bare avhengig av tekniske og juridiske krav, men også språklige og designmessige vurderinger. Forklaringen må tilpasses til målgruppen den retter seg mot. For eksempel trenger NAV-veiledereforklaringer som kan anvendes i praksis i en hektisk hverdag. NAV må derfor balansere og avveie mellom dybde og forenklinger som gjør det mulig å ta forklaringen i bruk. Forklaringen må dessuten integreres med øvrig informasjon veilederne har tilgang til. Et konkret eksempel er at NAV ikke kan presentere informasjon om hvordan 100 variabler har bidratt til en prediksjon. NAV må gruppere disse sammen og gjøre et utvalg. Det kreves i tillegg ekstra årvåkenhet dersom forklaringen retter seg mot barn eller sårbare grupper. NAVs modell vil kunne inkludere flere særskilte kategorier personopplysninger om sårbare grupper (for eksempel helseopplysninger om sykmeldte eller om personer har noe annet enn norsk som morsmål) og NAV vil derfor måtte vurdere å tilpasse språk, innhold og form basert på det.

Informasjon om data

Slik ser NAV for seg at man kan bli presentert hvilke data som brukes og legges til grunn på hvilken måte i modellen.

Når det gjelder NAV-veilederne er planen å forklare dem hvordan modellen virker generelt, og beskrive hvordan de skal bruke resultatet fra modellen i saksbehandlingsrutiner. I tillegg skal veilederne få forklaringer på enkeltsaksnivå og informasjonselementer modellen har lært fra som en del av informasjonsgrunnlaget for å ta den endelige avgjørelsen om brukeren kalles inn til dialogmøtet eller ikke. Prediksjonen skal inngå som ett av flere momenter som er tilgjengelig for veilederen, inkludert den informasjonen en veileder baserer en avgjørelse på i dag.

De to hovedmålgruppene for åpenhet om løsningen er altså brukere og veiledere. I tillegg er ledelsen i NAV, som behandlingsansvarlig for opplysningene i modellen, og tilsynsmyndigheter andre målgrupper som kan ha behov for og krav på en forklaring på hvordan algoritmen fungerer.

NAV ønsker å ta sin del av ansvaret når det gjelder åpenhet rundt bruken av algoritmer. Et mulig tiltak som NAV vurderer er å informere om hvordan NAV i stort ønsker å ta i bruk kunstig intelligens. NAV søker også å bidra til bred informasjon og opplyst debatt om bruken av kunstig intelligens gjennom mediebildet. Et siste tiltak er å informere og involvere brukerutvalg i forkant av og underveis i utviklingen av tjenester som baserer seg på kunstig intelligens.