Tiltak som kan redusere algoritmeskjevhet

I sandkasseprosjektet har vi diskutert hvordan Ahus kan redusere algoritmeskjevhet både i selve modellen, gjennom tekniske tiltak, og korrigere algoritmeskjevhet etter at algoritmen er tatt i bruk, gjennom organisatoriske tiltak.

Det presiseres i personvernforordningen fortalepunkt 71 at en rettferdig behandling av personopplysninger innebærer «gjennomføring av egnede tekniske og organisatoriske tiltak for særlig å sikre at faktorer som fører til uriktige personopplysninger, rettes opp og at risikoen for feil minimeres, sikre personopplysningene på en måte som tar hensyn til den registrertes interesser og rettigheter, og hindre blant annet forskjellsbehandling av fysiske personer (…)».

Likestillings- og diskrimineringsombudets kommentar:

Manglende presisjon i algoritmen for definerte pasientgrupper er ikke ensbetydende med at Ahus som rettssubjekt diskriminerer i sin praksis. Det avgjørende i henhold til likestillings- og diskrimineringsloven er at personer med diskrimineringsvern ikke «behandles dårligere enn andre», jf. § 7.

Det avgjørende i denne sammenheng er om forskjellsbehandlingen fører til «skade eller ulempe for den som forskjellsbehandles, for eksempel at forskjellsbehandlingen fører til tap av fordeler, økonomisk tap eller færre muligheter sammenlignet med andre i en tilsvarende situasjon. Forholdet må ha en konkret og direkte betydning for bestemte fysiske personer.»

(Prop. 81 L (2016-2017), kap. 30, kommentar til § 7)

Ombudet er av den oppfatning at Ahus kan kompensere for algoritmeskjevhet, ved å supplere med andre medisinske metoder i undersøkelse av pasientgruppene algoritmen ikke gir like gode prediksjoner for. Det avgjørende for å oppnå like god behandling for alle, er å vite hvilke pasientgrupper algoritmen er mindre presis for, og iverksette tiltak slik at disse pasientene får et like godt tilbud som andre.

Et generelt eksempel på tekniske tiltak er å pseudonymisere, kryptere eller anonymisere personopplysninger for å minimere personverninngrepet overfor den registrerte. Organisatoriske tiltak kan for eksempel være innføring og gjennomføring av rutiner og praksis som bidrar til at regelverket etterleves.

Les mer om implementering av egnede tiltak i programvareutvikling.

Tre typer tiltak

Vi har særlig fokusert på tre ulike typer tiltak i dette prosjektet:

- Analysere og kontrollere datagrunnlaget til algoritmen (teknisk tiltak)

- Etablere rutiner som sørger for opplæring av helsepersonell i bruk av beslutningsstøttesystemet (organisatorisk tiltak)

- Etablere en overvåkingsmekanisme for etterlæring (teknisk tiltak)

Teknisk tiltak: Analysere og kontrollere datagrunnlaget til algoritmen

I Nasjonal strategi for kunstig intelligens fremheves særlig skjevhet i datagrunnlaget som et hinder for inkludering og likebehandling. Dette forklares med at «datasett som brukes til å trene opp KI-systemer kan inneholde historiske skjevheter, være ufullstendige eller uriktige». Dårlig datakvalitet og feil i datagrunnlaget til EKG AI vil dermed forplante seg og forsterkes i algoritmen og kan føre til uriktige og diskriminerende resultater. Dårlig datakvalitet vil eksempelvis kunne forårsakes av gjentatte feildiagnostiseringer av helsepersonell. For at algritmen skal klare å finne et korrekt mønster i datasettet må opplysningene være konsistente og samsvare med virkelige fakta.

Ahus har benyttet historiske helsedata som har en statistisk sammenheng med risikoen for hjertesvikt. Datagrunnlaget til algoritmen består av resultater fra omtrent 100 000 elektrokardiogrammer (EKG-målinger), ICD-10 diagnosekoder for hjertesvikt og opplysninger om hjertets pumpeevne. Denne informasjonen er hentet fra kardiologisystemet og journalsystemet DIPS på Ahus.

I diskusjonen har vi særlig sett på to ulike metoder for å minimere algoritmeskjevhet i datagrunnlaget:

- Metode 1 tilfører ikke ny data til algoritmen, men man "blåser opp" de pasientgruppene som er underrepresenterte i datagrunnlaget. Utfordringen med denne metoden er at den gir bedre treffsikkerhet for enkelte pasientgrupper, men vil medføre dårligere presisjon for majoritetsgruppen av pasienter.

- Metode 2 tilfører algoritmen flere datapunkter (labels) knyttet til den underrepresenterte pasientgruppen. Man vil med denne teknikken måtte akseptere større grad av diskriminering i startfasen, men som over tid vil gi algoritmen bedre treffsikkerhet. Utfordringen med denne metoden er at man ikke nødvendigvis har opplysningene som er nødvendig for å rette opp i en avdekket skjevhet.

Det er først etter man har dokumentert en representasjonsskjevhet i algoritmen, at man kan iverksette korrigerende tiltak. Det har vært sentralt i diskusjonene å avdekke hvilke samfunnsgrupper som i liten grad er representert i datagrunnlaget til algoritmen. Vi har særlig diskutert representasjon av kjønn og etnisitet, da det finnes eksempler på tidligere algoritmer som har vist seg å diskriminere på disse grunnlagene.

Les Wired.com's artikkel om diskriminering av etniske minoriteter i helsevesenet og/eller Reuters artikkel om Amazons rekrutteringsalgoritme, som systematisk diskriminerte kvinnelige søkere.

Likestillings- og diskrimineringsombudets synspunkt:

I Ahus’ EKG AI-prosjekt er ombudet av den oppfatning at det er størst risiko for diskriminering knyttet til representasjonsskjevhet i datagrunnlaget. Forskningslitteraturen på hjertesvikt (se under) peker på at hjerterytmen varierer for ulike etnisiteter. Etniske minoriteter vil altså kunne ha varierende EKG-kurver enn majoritetsbefolkningen i Norge, noe som det bør tas høyde for både i utviklingen og anvendelsen av algoritmen.

Les forskningsartikkel om effekten avetnisitet på idrettsutøveres EKG på mdpi.com (eng)

Opplysninger om etnisitet registreres ikke i pasientjournalen, og finnes heller ikke tilgjengelig i andre nasjonale kilder. Det gir Ahus begrensede muligheter for å kontrollere om treffsikkerheten til algoritmen er dårligere for etniske minoriteter enn den etniske majoriteten av pasientene. For at Ahus skal få tilgang til disse opplysningene må det gjennomføres en klinisk studie basert på frivillig innsamling av data, og på denne måten få kontrollert algoritmens prediksjoner for denne pasientgruppen. I løpet av sandkasseprosjektet har Ahus argumentert for et behov for å registrere opplysninger om pasienters genetiske opphav for å sikre at helsetjenesten yter forsvarlig helsehjelp til alle. Registrering av etnisitet er et sensitivt tema, og hvorvidt, og hvordan dette kan gjennomføres i praksis er opp til nasjonale myndigheter å vurdere.

Kliniske studier

Ifølge Helsenorge.no er kliniske studier definert som «forskning på effekten av nye legemidler eller nye behandlingsmetoder, og på om bivirkningene er akseptable.»

Opplysninger om pasientens kjønn er en del av datagrunnlaget til EKG, kategorisert som «mann» og «kvinne». Hvorvidt algoritmen har lavere treffsikkerhet for pasienter som ikke definerer seg som mann eller kvinne, eller har gjennomgått kjønnsskorrigerende operasjon, finnes det ikke tall på. Dette må det i så fall opprettes en klinisk studie for å undersøke. Forekomsten av førstegangstilfeller av hjertesvikt har vært gjennomgående høyere blant menn enn kvinner. I følge Ahus, krever ulike typer av hjertesvikt ulik behandling og oppfølging, der kvinner er høyest representert i en av de tre typene av hjertesvikt. Som følge av at kvinner historisk sett har vært underrepresentert i medisinsk forskning, foreligger det en generell risiko for at kvinner kommer dårligerer ut enn menn når algoritmen er utviklet på historiske helseopplysninger. Ahus kan imidlertid bekrefte at det finnes et godt datagrunnlag for kvinnelige hjertesviktpasienter i EKG AI og at det derfor er liten sannsynlighet for diskriminering av kvinner i EKG AI.

Dersom algoritmen i fremtiden selges videre til andre aktører i, eller utenfor, Norge, oppstår det en fare for at datagrunnlaget ikke representerer den nye pasientgruppen algoritmen skal gi prediksjoner for. For å opprettholde en høy treffsikkerhet må algoritmen ettertrenes på ny og lokalt tilpasset pasientinformasjon, som vil bli behandlet nærmere under tiltak tre «Overvåkingsmekanisme for etterlæring».

Organisatorisk tiltak: Algoritme møter helsepersonell

Fram til nå har utviklingen av beslutningsstøtteverktøyet EKG AI foregått på laboratoriet. Det er nødvendig å gjennomføre en klinisk studie for å kontrollere algoritmens treffsikkerhet og presisjon på virkelige data før den tas i bruk i klinikk. For at beslutningsstøtteverktøyet skal fungere optimalt, må resultatet fra algoritmens beregninger presenteres for helsepersonellet på en måte som gjør at prediksjonen fungerer som tiltenkt, altså som et beslutningsstøtteverktøy for raskere diagnostisering av hjertesvikt enn i dag. Resultatet må nå frem til mottaker umiddelbart, helsepersonell må forstå svaret og kunne anvende det på riktig måte. Det overordnede målet er at EKG AI skal gi større treffsikkerhet og presisjon enn hva helsepersonell alene har kapasitet til, slik at den bidrar til forbedret og raskere helsehjelp.

Artikkel 22 i personvernforordningen oppstiller et forbud mot beslutninger som kun er basert på automatisert behandling. For at et slikt forbud skal gjøre seg gjeldende, må det være tale om en automatisert beslutning uten noe form for menneskelig innblanding. EKG AI skal brukes som et beslutningsstøtteverktøy og faller derfor ikke innenfor forbudet i artikkel 22. God informasjon og opplæring til helsepersonell om bruk av beslutningsstøtteverktøyet vil bidra til en reell menneskelig innblanding i beslutningsprosessen, og redusere risikoen for at helsepersonell legger algoritmens prediksjoner helt ukritisk til grunn i praksis.

Algoritmer er avanserte tekniske systemer som forutsetter både kunnskap hos, og opplæring av, helsepersonell. Det krever først og fremst at helsepersonell får en forklaring på hvordan algoritmen skal brukes, men også foreliggende risikofaktorer og feilmargin i prediksjonene. Helsepersonell må selv kunne forstå algoritmens funksjon og bakgrunn for prediksjonene, for å forhindre mistillit til verktøyet. Innsikt og forståelse for modellens virkemåte er også avgjørende for at helsepersonell kan vurdere prediksjonen på et selvstendig grunnlag. Dersom det i fremtiden viser seg at algoritmens treffsikkerhet varierer mellom ulike pasientgrupper, må dette også kommuniseres til helsepersonell. Opplæringen kan inkludere informasjon om diskrimeringsgrunnlag og at helsepersonell selv må være oppmerksom på disse.

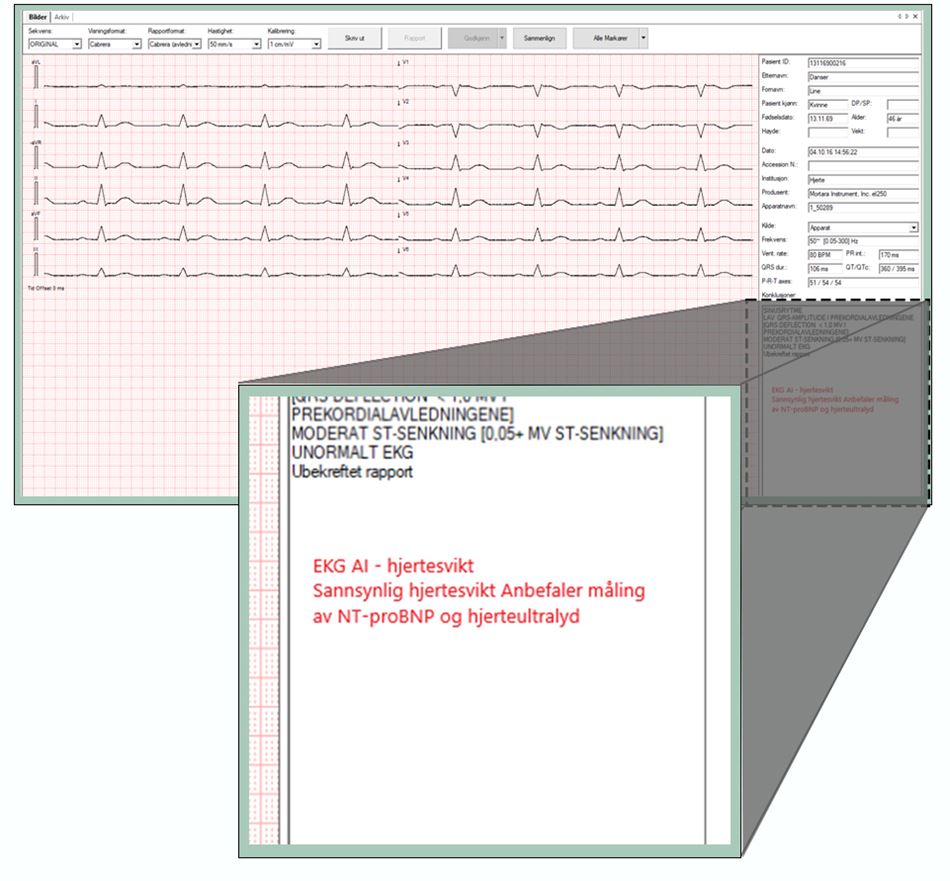

Helsepersonellet skal kun ta i bruk EKG AI algoritmen dersom det foreligger mistanke om hjertesvikt hos pasienten. Resultatet fra algoritmen sendes tilbake til EKG-arkivet (ComPACS) på Ahus. Svaret presenteres for helsepersonellet i et tekstlig format i et felt ved siden av pasientens EKG-måling. Ahus er klar over risikoen for alarmtrøtthet hos helsepersonell dersom mange varslinger, og mye informasjon, dukker opp samtidig. I og med at EKG AI skal brukes i en akuttsituasjon vil det særlig være viktig med klar og presis informasjon. I sandkasseprosjektet har vi derfor diskutert ulike måter prediksjonen kan presenteres på. Prediksjonen kan presenteres som prosenttall, kategoriene «lav», «middels» og «høy», eller det kan settes en grense for akutt/ikke akutt oppfølging. I denne prosessen vil det være hensiktsmessig å involvere helsepersonell for å få innspill til hvordan resultatene kan presenteres på en god måte. Hvordan prediksjonen helt konkret skal formuleres vil Ahus undersøke nærmere i en klinisk studie. Her vil man kunne teste ut beslutningsstøttverktøyet i praksis på et antall pasienter og med utvalgte helsepersonell.

Denne illustrasjonen viser hvordan resultatet fra EKG AI kan presenteres for helsepersonell.

Som følge av at resultatet fra algoritmen lagres i EKG arkivet (ComPacs), vil det foreligger en risiko for at resultatet ikke blir oppdaget av helsepersonell umiddelbart. Ahus vil derfor se på alternative muligheter for å varsle, for eksempel via skjermer på sykehuset eller på helsepersonellets jobbtelefon. Slike varslingsløsninger forutsetter imidlertid bedre infrastruktur enn det som finnes på Ahus idag.

I forbindelse med opplæring av helsepersonell vil Ahus etablere rutiner og protokoller for bruk av verktøyet. Når algoritmen videreutvikles er det naturlig at rutiner, protokoller og selve opplæringsløpet også oppdateres. Ahus har et eksisterende avvikssystem hvor helsepersonell melder inn avvik som kan brukes til å forbedre algoritmen i fremtiden.

Teknisk tiltak: Overvåkingsmekanisme for etterlæring

Med tiden og skiftende forhold i samfunnet vil EKG AIs prediksjoner bli mindre nøyaktige. Lavere treffsikkerhet vil naturligvis oppstå når en befolkningsmasse endrer seg. For eksempel kan det komme til nye pasientgrupper på grunn av økt flyktningestrøm fra et land algoritmen ikke tidligere har datagrunnlag på. Når treffsikkerheten ikke lenger er tilfredsstillende vil det være aktuelt med etterlæring av algoritmen. Etterlæring vil innebære trening med nye opplysninger, testing og validering av algoritmen.

EKG AI algoritmen vil ikke etterlæres kontinuerlig, som innebærer at nøyaktigheten ikke automatisk tilpasser seg fremtidige endringer. Ahus planlegger istedenfor å implementere en overvåkningsmekanisme som skal varsle når algoritmens treffsikkerhet faller under en forhåndsbestemt grenseverdi og algoritmen har behov for etterlæring. For å validere en slik grenseverdi vil Ahus gjennomføre en klinisk studie samtidig som algoritmen testes ut i klinikk.

Helt praktisk vil overvåkningsmekanismen sammenligne algoritmens prediksjoner med den diagnosen helsepersonellet stiller pasienten. På denne måten vil man kunne vurdere i hvilken grad algoritmen predikerer riktig i forhold til pasientens faktiske medisinske tilstand. Grenseverdien for treffsikkerhet vil deretter avgjøre når, og hvorvidt, det er behov for etterlæring av algoritmen.