Hvordan avdekke algoritmeskjevhet?

Kunstig intelligens har et stort potensiale til å forbedre diagnostikk og behandling av sykdom. Samtidig, har man i flere tilfeller sett at kunstig intelligens i stor grad viderefører og forsterker eksisterende diskriminering i samfunnet. Sandkasseprosjektet har ønsket å se nærmere på hvordan man kan avdekke potensielle skjevheter i EKG AI-algoritmen.

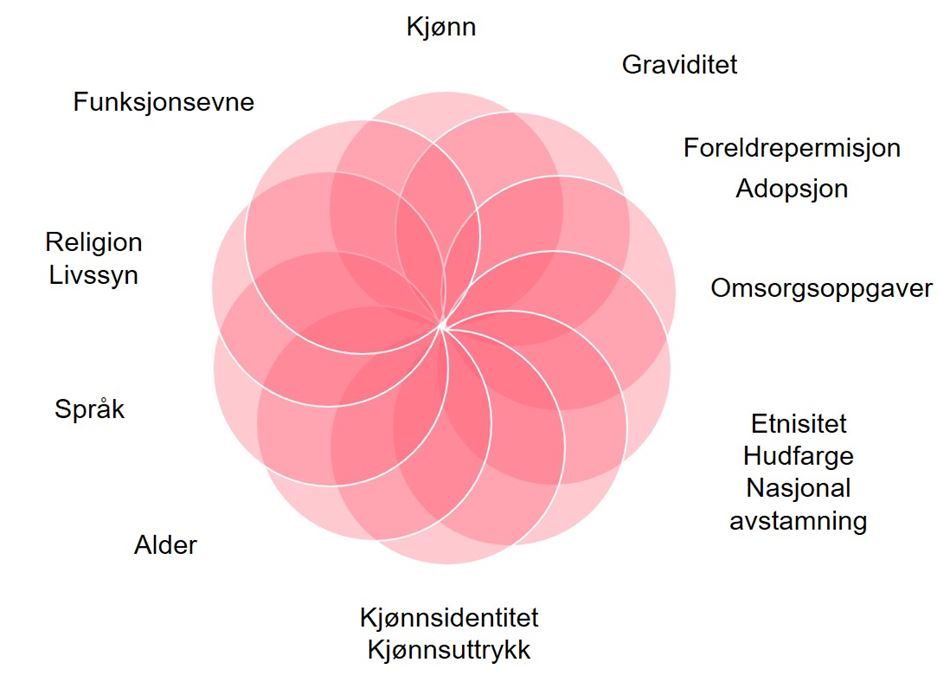

For å sikre en rettferdig algoritme ønsket vi å undersøke om EKG AI gir mindre treffsikre prediksjoner for enkelte pasientgrupper. Med god veiledning fra LDO, tok vi utgangspunkt i diskrimineringsgrunnlagene oppstilt i ldl. § 6. Vi ble oppmerksomme på at det i noen tilfeller ikke er tilstrekkelig å se på diskrimineringsgrunnlagene isolert, men krysskontrollere diskrimineringsgrunnlagene, som eksempelvis «minoritetskvinne».

Definisjon av diskriminering

For at forskjellsbehandlingen skal anses som diskriminering etter ldl. må den ha sin årsak i ett eller flere diskrimineringsgrunnlag.

Les mer om de ulike diskrimineringsgrunnlagene på Diskrimineringsnemda sin nettside.

I Norge har vi et gratis helsetilbud for alle, som legger et grunnlag for et representativt datagrunnlag med en stor variasjon av pasienter. Det kan likevel forekomme tilfeller der enkelte pasientgrupper ikke har hatt den samme tilgangen til en spesifikk behandling, og på denne måten utgjør en kilde til skjevhet i algoritmen. Vi har i prosjektet blant annet valgt å se nærmere på hvorvidt EKG AI gir varierende grad av treffsikre prediksjoner for pasienter med ulik etnisk bakgrunn. En av grunnene til at vi valgte å se nærmere på diskrimineringsgrunnlaget etnisitet var fordi det finnes flere eksempler på algoritmer som systematisk diskriminerer etniske minoriteter.

Fra et helseperspektiv kan ulik etnisk bakgrunn gi varierende symptomer på hjertesvikt, varierte EKG-målinger og blodprøver. I denne sammenheng er det viktig å presisere at begrepet «etnisitet» brukes som en referanse for pasientens biologiske eller genetiske opphav.

Utfordringen for Ahus er at det finnes ingen eller begrenset data om pasientenes etnisitet. Når Ahus ikke har tilgang til disse opplysningene vil det heller ikke være mulig å kontrollere hvorvidt algoritmen har mindre presise prediksjoner for denne pasientgruppen. For å være i stand til å avdekke om det eksisterer en slik skjevhet, må Ahus gjennomføre en klinisk studie. I denne studien kan opplysninger om etnisitet samles inn basert på samtykke og det vil være mulig å kontrollere om etniske minoriteter kommer systematisk dårligere ut enn majoriteten av pasientene algoritmen er trent på.

For å kunne kontrollere om det eksisterer skjevheter i EKG AI, må det først fastsettes en grenseverdi for statistisk usikkerhet i algoritmen. Som følge av at det alltid vil eksistere fordommer og diskriminering i den virkelige verden, vil også algoritmer inneholde feil og skjevheter. Det vesentlige har derfor vært å finne ut av hvor grensen går for en uakseptabel forskjellsbehandling i EKG AI.

Ønsket vs. uønsket forskjellsbehandling

Selve formålet med EKG AI er å prioritere de pasientene som har en pågående hjertesvikt, fremfor de som ikke har hjertesvikt. Dette er en form for forskjellsbehandling. Det avgjørende i vurderingen etter diskrimineringsregelverket er om det skjer en usaklig forskjellsbehandling.

For å kunne fastsette en slik grenseverdi må det gjennomføres en klinisk studie som undersøkeler om algoritmen har en redusert nøyaktighet for enkelte pasientgrupper basert på et eller flere diskrimineringsgrunnlag. Viser det seg for eksempel at EKG AI prioriterer pasientgrupper på grunnlag av etnisitet istendefor medisinske faktorer som EKG, diagnosekoder etc., vil dette anses som en usaklig forskjellsbehandling etter diskrimineringsregelverket.

Når man skal kontrollere om det eksisterer diskriminering i algoritmer, kreves det som regel innsamling og behandling av nye personopplysninger. Et nytt formål krever derfor en ny vurdering av behandlingens rettslig grunnlag etter artikkel 6, og eventuelt artikkel 9, i personvernforordningen.

Det er interessant å merke seg at EU-kommisjonens forslag til ny forordning om kunstig intelligens (AI act) artikkel 10-5 oppstiller en adgang til å behandle særlige kategorier av personopplysninger, som for eksempel helseopplysninger, dersom det er strengt nødvendig, til formål om å overvåke, oppdage og korrigere algoritmeskjevhet. Blir denne bestemmelsen vedtatt har man et lovgrunnlag for å i enkelte tilfeller kunne undersøke om det eksisterer diskriminering i algoritmer ved behandling av særlig kategorier av personopplysninger.

Dataminimeringsprinsippet i personvernforordningen artikkel 5 vil likevel sette en begrensning for hvilke personopplysninger man kan behandle. Prinsippet krever at opplysningene som behandles skal være adekvate, relevante og begrenset til det som er nødvendig for å oppnå formålet med behandlingen. Nødvendighetskravet inneholder også en vurdering av behandlingens forholdsmessighet. I vurderingen av om Ahus skal samle inn og behandle opplysninger om pasienters etnisitet, har vi derfor vurdert om det er forholdsmessig sett opp mot konsekvensene en potensiell skjevhet i algoritmen vil ha for den enkelte pasient.

Prediksjonene fra EKG AI brukes kun som én av mange informasjonskilder i helsepersonellets vurdering av den videre oppfølging av pasienten. Dette innebærer at konsekvensen av en eventuell skjevhet i algoritmen vil utgjøre en liten skaderisiko. Dersom algoritmen for eksempel ikke fanger opp hjertesvikt hos en pasient (falsk negativ), vil likevel hjertesvikten kunne avdekkes med ultralyd av hjertet og etterfølgende blodprøver. Ahus må derfor stille seg spørsmål om innsamling og behandling av opplysninger om etnisitet, som er særlige kategorier av personopplysninger, er en forholdsmessig behandling sett opp mot å avdekke en eventuell diskriminering i algoritmen.

Det finnes ingen klare svar på hvor en slik grense skal settes. I noen tilfeller er det først etter at opplysningene er samlet inn og behandlet at man kan si noe om behandlingen har vært nødvendig for å avdekke diskriminering. I medisinsk sammenheng er det imidlertid like viktig å få avdekket hva som ikke er relevant, som hva som anses relevant for forsvarlig helsehjelp.